Par Marie Zumstein (licence de droit international et européen de l’Université Paris-1 Panthéon-Sorbonne) étudiante au doctorat, option innovation, science et technologie à la Faculté de droit de l’Université de Montréal et chercheuse étudiante au regroupement JusticIA de l’Université de Montréal.

Photo @Marie Zumstein

La création d’une nouvelle technologie et sa mise en place au sein d’une société ne suffisent pas en elles-mêmes. Encore faut-il en effet que cette dernière soit bien accueillie par la population concernée. Ainsi, longtemps ignoré, le concept d’acceptabilité sociale des nouvelles technologies se fait de plus en plus important dans les réflexions qui encadrent leur développement. Comment faire en sorte que les citoyens adhèrent à celles-ci? Comment « mériter » la confiance des individus envers ces nouvelles innovations auxquelles ils ne sont pas habitués? De telles considérations sont essentielles dans la mesure où évidemment, plus une technologie est acceptée … plus elle sera utilisée! Et dans le même temps, plus la population s’en montre réticente et méfiante … et moindre sera l’impact espéré, engendrant déceptions et difficultés puisque malgré l’existence de risques certains, les bénéfices sont eux aussi réels et nombreux. Quel intérêt, dès lors, de développer de nouvelles technologies si une part importante, voire même une majorité de la population refuse de les utiliser dans leur vie quotidienne? Intimement liée à la notion de confiance, l’acceptabilité sociale des nouvelles technologies s’avère cruciale pour l’efficacité, le développement et la démocratisation de celles-ci.

Acceptabilité sociale : les applications de traçage de la Covid-19 dans l’Union européenne

Le développement et les difficultés d’implantation des applications de traçage (aussi appelées « applications de notifications d’exposition » selon leur nature) de la Covid-19 dans l’Union européenne illustrent très bien cette importance fondamentale. Bien qu’une union régionale prônant une organisation harmonisée au sein de ses États membres, il semble que ces derniers ne soient finalement pas parvenus à une entente sur laquelle fonder une application commune. Ceci, notamment liés aux désaccords sur la manière de stocker et de protéger les données personnelles des citoyens, des préoccupations pourtant censées être résolues par les dispositions du RGDP et notamment son article 5 relatif à la collecte, (para. 1.a), à la conservation (para 1.e) ou au traitement (para. 1.f et article 6) de celles-ci. Deux dynamiques semblent alors s’affronter sur le vieux continent.

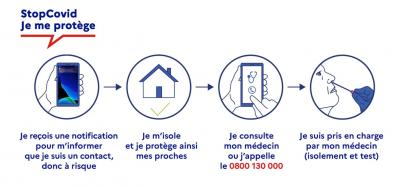

En France, l’application StopCovid est bien loin du succès escompté : depuis sa mise en circulation le 2 juin dernier, à peine 2% des Français l’ont téléchargée. Or, pour être efficace, une telle application doit être utilisée par une proportion plus importante de la population. La France n’est pas la seule à peiner à mettre en place un système de traçage qui se veut efficace. C’est aussi le cas d’autres États comme l’Autriche, la Norvège ou la Grande-Bretagne qui face aux résistances et aux critiques, ont dû s’y reprendre à plusieurs fois avant de proposer une application la plus sécuritaire possible. À l’inverse, en Italie ou en Allemagne, les applications de traçage de la Covid-19, pourtant basées sur un fonctionnement similaire à StopCovid, remportent un succès direct plus important (bien que moindre qu’espéré pour les rendre pleinement efficaces). Ainsi en Allemagne, Corona-Warn-App, mise en place avec la collaboration de Google et d’Apple, a été téléchargée par plus de 10% de la population en à peine 4 jours. Comment alors, expliquer de telles différences ?

Pourquoi ces applications rencontrent-elles si peu de succès ?

En Europe, les citoyens ont tendance à se méfier des applications de ce type, craignant pour leurs données personnelles fondamentalement associées à la vie privée, et craignant aussi de se faire épier par les gouvernements nationaux. Pour tenter d’y remédier et encourager le téléchargement des applications de traçage en temps de Covid, les États européens ont adopté deux stratégies différentes pour le développement de leurs applications. Tandis que dans une minorité de pays comme en France on se base sur une approche centralisée pour l’hébergement des données, dans d’autres endroits comme en Allemagne ou en Italie, à l’opposé, on opte plutôt pour une démarche décentralisée. Ainsi, les données sont stockées sur le téléphone uniquement, ce qui permet d’éviter les récupérations douteuses, notamment par les gouvernements … et qui permet dans le même temps d’assurer une meilleure confidentialité des données. À l’inverse, dans le premier cas, les données sont transmises à un serveur externe centralisé, posant des interrogations quant au à leur traitement et à leur utilisation par une entité extérieure. Cette manière différente d’aborder et de protéger les données personnelles a nécessairement un impact sur la manière dont les citoyens abordent l’application de traçage. La Grande-Bretagne qui a dans un premier temps réfléchit à une application centralisée change finalement son fusil d’épaule et le Canada a lui-aussi adopté un tel modèle décentralisé pour sa future application Shopify-Covid Alert. Ainsi, il est intéressant de constater que les endroits où l’application rencontre le moins de succès sont ceux qui ont choisis un fonctionnement centralisé dans le traitement des données … une option délaissée par de plus en plus d’États européens au profit d’un système décentralisé sur le modèle allemand. Un hasard? La décentralisation des données est certainement un facteur non-négligeable, même si ce n’est sans doute pas le seul et unique élément qui participe à favoriser, ou non, la confiance de la population envers elle.

La compréhension de l’application (ou de la technologie en général) mais également des bénéfices qui peuvent en découler jouent un rôle primordial dans l’acceptabilité sociale. Des chercheurs de l’Université d’Oxford ont observé que le taux d’utilisation des applications de traçage de la Covid-19 augmentait si leur utilité et fonctionnement étaient correctement expliqué aux utilisateurs.

It’s not something that would typically happen for a new app – even an incredibly popular one – but if we can explain that this is a public health intervention, that will be new and different. […] More than 80% of people surveyed said they were likely to or would install this app when it was explained in detail what it would be doing.

Pr. Fraser, Université d’Oxford

The successful and appropriate use of mobile phone apps to facilitate instantaneous contact tracing in the context of COVID-19 in democratic countries depends on the establishment of sustained and well-founded public trust and confidence. This applies to the use of the app itself and of the data. […] However, in democratic contexts, in addition to the provision of clearly articulated and justified answers to the questions set out above, requirements are likely to include: […] the use of a transparent, auditable and easily explained algorithm; the highest possible standards of data security; and effective protections around the ownership uses of data.

M.J. Parker, C. Fraser, L. Abeler-Dörner et al., «Ethics of instantaneous contact tracing using mobile phone apps in the control of the COVID-19 pandemic», (2020) Journal of Medical Ethics.

Ainsi, ils affirment que le succès de ce type d’application dépend de son bien-fondé éthique mais aussi, de la confiance du public envers celle-ci. Le manque d’information sur l’application, ou de compréhension quant à son intérêt, sont autant de facteurs qui peuvent réduire les chances de la technologie d’être acceptée par la société. Sans information vulgarisée à destination de tous, la méfiance est inévitablement de mise, en raison notamment des fantasmes qui entourent les nouvelles technologies. Ainsi, peut-on vraiment reprocher aux Français de ne pas avoir confiance dans une application qui ne fait l’unanimité ni dans l’opposition, ni dans la majorité politique elle-même?

Acceptation sociale, droit et nouvelles technologies

L’acceptation sociale d’une nouvelle technologie est donc essentielle pour sa diffusion dans la société. Un manque de confiance de la population pourrait alors bloquer potentiellement son déploiement, son développement mais aussi la recherche dans ces nouvelles technologies. L’UE l’a bien compris puisqu’en matière d’intelligence artificielle, la Commission a publié en février dernier un Livre blanc intitulé « Intelligence artificielle, une approche européenne axée sur l’excellence et la confiance » dans lequel elle réfléchit avant tout aux moyens de renforcer la confiance des différents acteurs de la population envers les IA :

Les éléments clés d’un futur cadre réglementaire pour l’IA en Europe, qui créera un «écosystème de confiance» unique en son genre. Pour ce faire, il devra garantir le respect des règles de l’UE, notamment celles qui protègent les droits fondamentaux et les droits des consommateurs, en particulier pour les systèmes d’IA à haut risque exploités dans l’UE. La création d’un écosystème de confiance est un objectif stratégique en soi, qui devrait susciter chez les citoyens la confiance nécessaire pour adopter les applications d’IA et donner aux entreprises et aux organismes du secteur public la sécurité juridique voulue pour innover au moyen de l’IA.

Et le droit dans tout ça? Quel rôle a-t-il dans l’acceptabilité sociale de ces nouvelles technologies? Il apparaît que la méfiance de la population envers ces innovations est généralement due à des facteurs récurrents dont certains ont été évoqués ci-dessus :

- le manque de compréhension et d’information. Si l’on prend l’exemple des IA, l’image que se fait les individus de celle-ci se construit souvent par la science-fiction … des scénarios pourtant bien loin de la réalité;

- la complexité, dans la mesure où le fonctionnement de ces nouvelles technologies est relativement dur à comprendre, d’où l’importance de la vulgarisation;

- les risques, particulièrement pour la sécurité ou sur les droits humains, ce qui n’est pas négligeable puisque certains de ces risques sont encore incertains, voire inconnus, que ce soit à court ou à long terme.

Le droit est d’autant plus important puisqu’il peut permettre de réduire ces risques et craintes.

Afin de favoriser l’acceptabilité sociale, il devra d’abord encadrer de manière éthique la création, le développement et l’implantation de ces nouvelles technologies en faisant par exemple participer les citoyens aux débats (pour ce faire, la Déclaration de Montréal s’avère un bon modèle pour favoriser la confiance envers l’IA). Il devra également participer à réduire les risques potentiels qui pourraient survenir, et veiller à placer le respect et la protection des droits et libertés fondamentales des personnes au-dessus de toutes les autres considérations (c’est d’ailleurs dans cette direction que se dirige la législation européenne en matière d’IA, si on se fie à son Livre blanc). Tout cela, en mettant en place des mesures pour renforcer la transparence à tous les stades de développement de la nouvelle technologie afin que son intérêt pour le bien public et son fonctionnement soient compris du plus grand nombre. Si ces conditions sont réunies, alors les nouvelles technologies s’installeront plus facilement dans nos vies quotidiennes, accompagnant le progrès dans le but d’améliorer la société.

Ce contenu a été mis à jour le 10 février 2022 à 16 h 05 min.

Commentaires

3 commentaires pour “Acceptabilité sociale des nouvelles technologies : le cas des applications de traçage en temps de Covid”

Zumstein

16 octobre 2020 à 4 h 34 minTrès intéressant, j’ai appris beaucoup de choses et c’est plus clair pour moi !